本文的閱讀等級:中級

最佳化理論 (優化理論,optimization theory) 提供許多應用於社會、自然與工程科學的數值算法。給定一個目標函數或稱成本函數 ,無約束優化 (unconstrained optimization) 是指找到

使得

有最小值,表示如下:

。

在一些應用場合,如果我們希望找到最大值,只要改變目標函數的正負號即可。對一般的目標函數 ,這是一個很困難的問題,通常我們願意接受局部最小值 (稍後詳述),意思是在某個範圍內的最小值。底下我們先考慮單變數的目標函數,隨後再推廣至多變數函數。本文的主旨在介紹無約束優化的一些基本概念並解釋正定矩陣於判定極值 (最大或最小) 存在性的用途。

令 為一個定義於

的光滑可導實函數,其中

是一個開集。泰勒 (Taylor) 定理說

可表示為下列展開式:

。

若 ,我們稱

為

的一個駐點 (stationary point),也稱臨界點 (critical point)。若

足夠小,鄰近

的

函數近似於一個二次函數:

。

如果 ,我們稱

為一個局部最小值 (local minimum)。嚴謹的說法是:存在一個

,對於所有

滿足

都有

。如果

,我們稱

為一個局部最大值 (local maximum)。又如果

,則必須直接計算

和

才能決定

的屬性。因此,

,即駐點

是函數

的一個局部最小值的必要條件。

前述單變數分析可延伸至多變數問題,假設函數 由

個變數

所控制,令向量

,

為定義於

的可導實函數,泰勒定理的多變數形式為

定義函數 於點

的梯度 (gradient) 為一個

維向量,其中第

元為

對於

的一次偏導數,如下:

。

另定義 階矩陣

為

於點

的 Hessian 矩陣,其

元為

的二次偏導數,如下:

。

多變量泰勒定理可用矩陣形式表示為

。

若 是一個駐點,即

,當

足夠小,

。

使用導數法則,

,

可知 是一個對稱矩陣。若

是正定的,即

,可知

,

是

的一個局部最小值 (見“特殊矩陣 (6):正定矩陣”);反之,若

是負定的,則

是

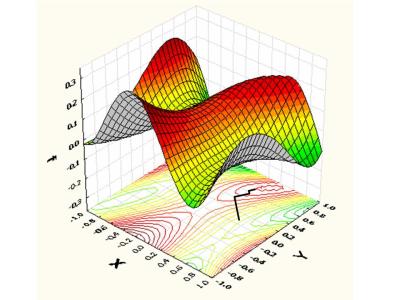

的一個局部最大值。見圖一,目標函數

有兩個局部最大值在 和

。

如果 是未定的,則

稱為鞍點 (saddle point),例如,

,其梯度為

,Hessian 是

。

因為 有特徵值

和

,可知

是未定的,函數

的鞍點在

,見圖二。

給定一個可導實函數 ,如何找出其局部最小值呢?如要找尋

的局部最大值可轉換為找尋

的局部最小值。這個問題屬於最佳化理論的範疇,下面我介紹一個常用的一階演算法,稱為梯度下降法 (gradient descent)。梯度下降法假設已知一個初始點

,你站在該點沿著

的最陡下降方向移動,該方向即為

於點

的梯度相反方向,算式如下:

,

其中 表示移動的步伐大小。只要

足夠小且

,便可以保證

,利用泰勒定理可證明此性質。考慮

於點

的泰勒展開式:

。

將梯度下降法給出的關係式 代入上式,得到

。

不論 是正定、負定或未定的,我們總能選擇夠小的正數

使得

。

我將梯度下降法整理於下:給定一個初始點 ,根據遞迴公式

,

就有

。

適當選擇夠小的步伐 ,向量序列

最終會收斂至

的一個局部最小值。看下面的例子[1]:

。

如果我們希望找尋局部最大值,可將梯度下降改為梯度上升 (gradient ascent),也就是選擇 。圖三顯示三維空間函數面圖形與平面輪廓圖的梯度上升軌跡,明顯地,梯度上升法收斂至哪一個局部最大值由給出的初始點位置所決定。

註解

[1] 取自維基百科http://en.wikipedia.org/wiki/Gradient_descent

老師,請問一下上面那個泰勒定理的多變量形式的二次項是否少了係數 1/2 呢?

謝謝指正。錯誤還不少,一併訂正了。

老師,文章的開頭,若y是f(x)的局部最小值,那麼對所有滿足|x-y|=f(y),不等號的方向反了吧?

感謝指正。難怪出版社需要editor,書寫者總是看不到自己的錯誤。

說來慚愧,我也是第二次讀老師的文章的時候才發現。